ПНСТ 836-2023

(ISO/IEC DTR 5469)

ПРЕДВАРИТЕЛЬНЫЙ НАЦИОНАЛЬНЫЙ СТАНДАРТ РОССИЙСКОЙ ФЕДЕРАЦИИ

ИСКУССТВЕННЫЙ ИНТЕЛЛЕКТ

Функциональная безопасность и системы искусственного интеллекта

Artificial intelligence. Functional safety and Al systems

ОКС 35.020

Срок действия с 2024-01-01

до 2027-01-01

Предисловие

1 ПОДГОТОВЛЕН Федеральным государственным автономным образовательным учреждением высшего образования "Национальный исследовательский университет "Высшая школа экономики" (НИУ ВШЭ) на основе собственного перевода на русский язык англоязычной версии проекта стандарта, указанного в пункте 4

2 ВНЕСЕН Техническим комитетом по стандартизации ТК 164 "Искусственный интеллект"

3 УТВЕРЖДЕН И ВВЕДЕН В ДЕЙСТВИЕ Приказом Федерального агентства по техническому регулированию и метрологии от 29 ноября 2023 г. N 75-пнст

4 Настоящий стандарт является модифицированным по отношению к проекту международного стандарта ISO/IEC DTR 5469* "Искусственный интеллект. Функциональная безопасность и системы искусственного интеллекта" (ISO/IEC DTR 5469 "Artificial intelligence - Functional safety and Al systems", MOD) путем изменения отдельных ссылок, которые выделены в тексте курсивом**, для учета особенностей российской национальной стандартизации.

При этом в него не включена таблица 3 примененного проекта международного стандарта, которую нецелесообразно применять в российской национальной стандартизации. Указанная таблица, не включенная в основную часть настоящего стандарта, приведена в дополнительном приложении ДА

Правила применения настоящего стандарта и проведения его мониторинга установлены в ГОСТ Р 1.16-2011** (разделы 5 и 6).

Федеральное агентство по техническому регулированию и метрологии собирает сведения о практическом применении настоящего стандарта. Данные сведения, а также замечания и предложения по содержанию стандарта можно направить не позднее чем за 4 мес до истечения срока его действия разработчику настоящего стандарта по адресу: [email protected] и/или в Федеральное агентство по техническому регулированию и метрологии по адресу: 123112 Москва, Пресненская набережная, д.10, стр.2.

В случае отмены настоящего стандарта соответствующая информация будет опубликована в ежемесячном информационном указателе "Национальные стандарты" и также будет размещена на официальном сайте Федерального агентства по техническому регулированию и метрологии в сети Интернет (www.rst.gov.ru)

Введение

Использование технологии ИИ значительно расширилось в последние годы и преимущество ИИ в некоторых сферах применения очевидно. Однако на данный момент имеется очень мало руководств по спецификации, проектированию, верификации функционально безопасных систем ИИ или по применению технологии ИИ для таких функций, которые связаны с безопасностью. Функции, реализуемые с помощью технологии ИИ, например МО, трудно объяснимы, и еще сложнее гарантировать их функционирование. Таким образом, где бы ни применялась технология ИИ, и особенно если она применяется для реализации систем, связанных с безопасностью, с большой долей вероятности возникают особые обстоятельства, требующие рассмотрения.

Доступность мощных технологий вычисления и хранения данных делает возможным применение МО в широких масштабах. Для все возрастающего числа сфер деятельности применение МО как технологии ИИ позволяет быстро и успешно разрабатывать алгоритмы, которые обнаруживают закономерности и тренды в данных. МО может также использоваться для идентификации аномального поведения или схождения функции на оптимальном решении в особой среде. МО с успехом применяется для анализа данных в финансовой сфере, в приложениях социальных сетей, для распознания речи и изображений (особенно при опознании личности), а также в управлении здравоохранением и прогнозировании, для создания цифровых ассистентов, промышленных роботов, для мониторинга состояния здоровья и в беспилотных транспортных средствах.

В дополнение к МО другие технологии ИИ приобретают важное значение в инженерных приложениях. Прикладная статистика, теория вероятности и теория статистического оценивания способствовали значительному прогрессу в сфере роботизации и распознавания образов. В результате технологии ИИ и системы ИИ начинают применяться в приложениях, которые имеют отношение к безопасности.

МО может использоваться для создания моделей, таким образом расширяя понимание окружающего мира. Но модели, полученные в результате МО, хороши лишь настолько, насколько качественной была информация, использованная при создании модели. Если обучающие данные не отражают достаточное число значимых сценариев применения, то полученные модели могут быть неверными. По мере поступления новых наблюдений они могут использоваться для подкрепления модели, но это, в свою очередь, может привести к необъективности в относительной важности наблюдений, что может сместить поведение алгоритма в сторону от менее частотных, но все-таки реальных типов поведения. Непрерывное дообучение и подкрепление модели новыми примерами помогает приблизить параметры модели к оптимальным значениям, но также возможен и побочный эффект: настройка преимущественно на типовые входные данные может снизить качество применения модели для экстремальных, хотя не менее важных, входных данных.

Цель настоящего стандарта заключается в том, чтобы дать возможность разработчику систем, связанных с безопасностью, применить надлежащим образом технологии ИИ как часть функций безопасности, используя понимание характеристик, факторов риска, существующих методов анализа функциональной безопасности и потенциальные ограничения технологий ИИ. В настоящем стандарте также приведена информация о проблемах и концепциях решений, связанных с функциональной безопасностью систем ИИ.

Целью настоящего стандарта не является установление требований. Описание требований к уровню полноты безопасности, позволяющих использовать элемент ИИ в функции безопасности с определенным уровнем полноты безопасности или уровень полноты автомобильной безопасности, находятся за пределами области применения настоящего стандарта.

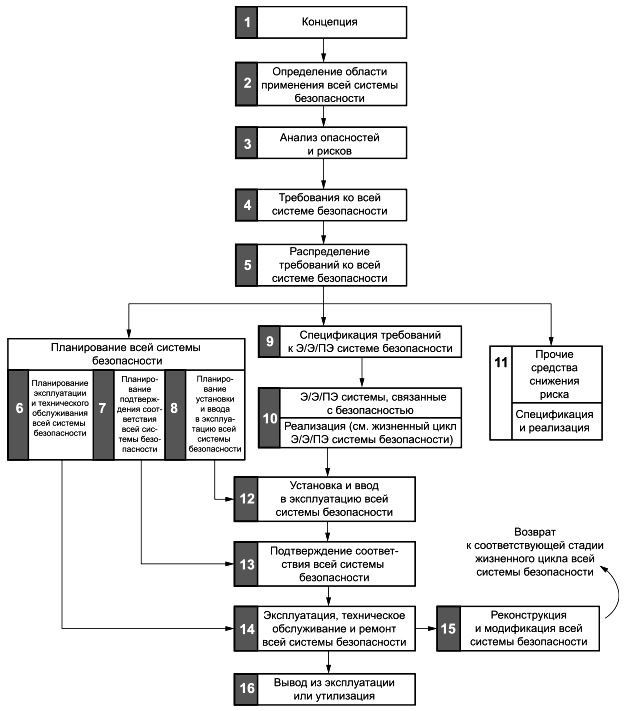

В разделе 5 приведены общие положения функциональной безопасности и ее связи с технологией и системами ИИ.

В разделе 6 представлены разные классы технологии ИИ, чтобы показать их соответствие существующим стандартам функциональной безопасности в том случае, когда технология ИИ является частью функции безопасности. В разделе 6 также представлены разные уровни использования технологии ИИ в зависимости от их конечного воздействия на систему. Наконец, в разделе 6 приведена качественная оценка соответствующих уровней функциональной безопасности с разными сочетаниями класса технологии ИИ и уровня использования.

В разделе 7 предложен метод для использования технологии ИИ в системах, связанных с безопасностью, в которых соответствие существующим стандартам функциональной безопасности не может быть прямо продемонстрировано.

В разделе 8 приведены характеристики и связанные с ними факторы риска для функциональной безопасности в системах ИИ. Приведено описание проблем, связанных с использованием ИИ, и характеристик, которые могут быть приняты во внимание при попытке решить эти проблемы или ослабить их воздействие.

В разделах 9-11 приведены возможные решения указанных проблем в области верификации и валидации, управления и защитных мер, процессов и методик.

В приложениях приведены примеры применения настоящего стандарта и дополнительная информация. В приложении A показано, как ГОСТ IEC 61508-3 применяется к элементам технологии ИИ. В приложении B приведен пример применения принципа трехступенчатой реализации и определения разнообразных характеристик. В приложении C дано детальное описание процессов, описанных в 9.3. В приложении D показана связь между жизненным циклом безопасности, установленным в ГОСТ Р МЭК 61508-1, и жизненным циклом системы ИИ, установленным в [1].

1 Область применения

В настоящем стандарте приведено описание свойств, соответствующих факторов риска, существующих методов и процессов, связанных с применением:

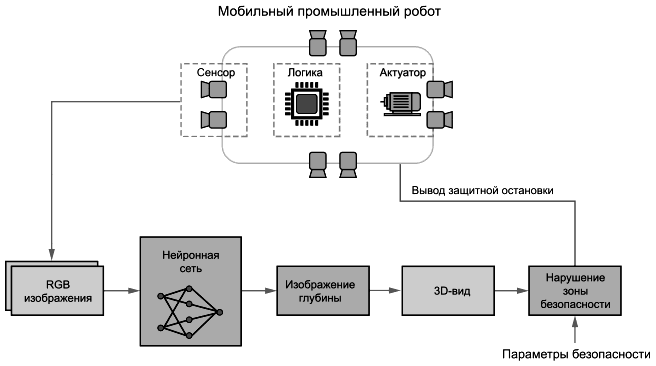

- ИИ внутри функции, связанной с обеспечением безопасности, для реализации соответствующего функционала;

- функций обеспечения безопасности без использования ИИ для обеспечения безопасности оборудования, управляемого ИИ;

- систем ИИ для проектирования и создания функций обеспечения безопасности.

2 Нормативные ссылки

В настоящем стандарте использованы нормативные ссылки на следующие стандарты:

ГОСТ IEC 61508-3-2018 Функциональная безопасность систем электрических, электронных, программируемых электронных, связанных с безопасностью. Часть 3. Требования к программному обеспечению

ГОСТ ISO 12100 Безопасность машин. Основные принципы конструирования. Оценки риска и снижения риска

ГОСТ Р 59276-2020 Системы искусственного интеллекта. Способы обеспечения доверия. Общие положения

ГОСТ Р 70462.1-2021/ISO/IEC TR 24029-1-2021 Информационные технологии. Интеллект искусственный. Оценка робастности нейронных сетей. Часть 1. Обзор

ГОСТ Р ИСО 26262-1 Дорожные транспортные средства. Функциональная безопасность. Часть 1. Термины и определения

ГОСТ Р ИСО 26262-5 Дорожные транспортные средства. Функциональная безопасность. Часть 5. Разработка аппаратных средств изделия

ГОСТ Р ИСО 26262-6-2021 Дорожные транспортные средства. Функциональная безопасность. Часть 6. Разработка программного обеспечения изделия

ГОСТ Р ИСО/МЭК 18045 Информационная технология. Методы и средства обеспечения безопасности. Методология оценки безопасности информационных технологий

ГОСТ Р ИСО/МЭК ТО 19791 Информационная технология. Методы и средства обеспечения безопасности. Оценка безопасности автоматизированных систем

ГОСТ Р ИСО/МЭК 25010 Информационные технологии. Системная и программная инженерия. Требования и оценка качества систем и программного обеспечения (SQuaRE). Модели качества систем и программных продуктов

ГОСТ Р ИСО/МЭК 27001 Информационная технология. Методы и средства обеспечения безопасности. Системы менеджмента информационной безопасности. Требования

ГОСТ Р МЭК 61508-1-2012 Функциональная безопасность систем электрических, электронных, программируемых электронных, связанных с безопасностью. Часть 1. Общие требования

ГОСТ Р МЭК 61508-2 Функциональная безопасность систем электрических, электронных, программируемых электронных, связанных с безопасностью. Часть 2. Требования к системам

ГОСТ Р МЭК 61508-4-2012 Функциональная безопасность систем электрических, электронных, программируемых электронных, связанных с безопасностью. Часть 4. Термины и определения

ГОСТ Р МЭК 61508-7-2012 Функциональная безопасность систем электрических, электронных, программируемых электронных, связанных с безопасностью. Часть 7. Методы и средства

ГОСТ Р МЭК 61511-1 Безопасность функциональная. Системы безопасности приборные для промышленных процессов. Часть 1. Термины, определения и технические требования

ГОСТ Р МЭК 62443-2-1 Сети коммуникационные промышленные. Защищенность (кибербезопасность) сети и системы. Часть 2-1. Составление программы обеспечения защищенности (кибербезопасности) системы управления и промышленной автоматики

ГОСТ Р МЭК 62443-3-3 Сети промышленной коммуникации. Безопасность сетей и систем. Часть 3-3. Требования к системной безопасности и уровни безопасности

ПНСТ 839-2023 (ISO/IEC TR 24027:2021) Искусственный интеллект. Смещенность в системах искусственного интеллекта и при принятии решений с помощью искусственного интеллекта

Примечание - При пользовании настоящим стандартом целесообразно проверить действие ссылочных стандартов в информационной системе общего пользования - на официальном сайте Федерального агентства по техническому регулированию и метрологии в сети Интернет или по ежегодному информационному указателю "Национальные стандарты", который опубликован по состоянию на 1 января текущего года, и по выпускам ежемесячного информационного указателя "Национальные стандарты" за текущий год. Если заменен ссылочный стандарт, на который дана недатированная ссылка, то рекомендуется использовать действующую версию этого стандарта с учетом всех внесенных в данную версию изменений. Если заменен ссылочный стандарт, на который дана датированная ссылка, то рекомендуется использовать версию этого стандарта с указанным выше годом утверждения (принятия). Если после утверждения настоящего стандарта в ссылочный стандарт, на который дана датированная ссылка, внесено изменение, затрагивающее положение, на которое дана ссылка, то это положение рекомендуется применять без учета данного изменения. Если ссылочный стандарт отменен без замены, то положение, в котором дана ссылка на него, рекомендуется применять в части, не затрагивающей эту ссылку.

3 Термины и определения

В настоящем стандарте применены термины по [2], а также следующие термины с соответствующими определениями.

3.1

безопасность (safety): Отсутствие неприемлемого риска. [ГОСТ Р МЭК 61508-4-2012, статья 3.1.11] |

3.2 |

функциональная безопасность (functional safety): Часть общей безопасности, обусловленная применением УО и системы управления УО и зависящая от правильности функционирования Э/Э/ПЭ систем, связанных с безопасностью, и других средств по снижению риска. [ГОСТ Р МЭК 61508-4-2012, статья 3.1.12] |

3.3 |

риск; риск функциональной безопасности (risk; functional safety risk): Сочетание вероятности события причинения вреда и тяжести этого вреда. Примечание - Дальнейшее обсуждение этого определения содержится в МЭК 61508-5, приложение A. [ГОСТ Р МЭК 61508-4-2012, статья 3.1.6] |

3.4 |

риск; организационный риск (risk; organizational risk): Следствие влияния неопределенности на достижение поставленной цели. Примечание 1 - Под следствием влияния неопределенности необходимо понимать отклонение от ожидаемого результата или события (позитивное и/или негативное). Примечание 2 - Цели могут быть различными по содержанию (в области экономики, здоровья, экологии и т.п.) и назначению (стратегические, общеорганизационные, относящиеся к разработке проекта, конкретной продукции и процессу). Примечание 3 - Риск часто характеризуют путем описания возможного события (3.5) и его последствий (3.6) или их сочетания. Примечание 4 - Это общее определение риска. Поскольку риски рассматриваются узко с точки зрения вреда (3.5), специализированное значение термина "риск" (3.3) используется в настоящем стандарте в дополнение к общему определению термина. [Адаптировано из ГОСТ Р ИСО 31000-2019, пункт 3.1] |

3.5 |

вред (harm): Физические повреждения или ущерб, причиняемый здоровью людей, имуществу или окружающей среде. [ГОСТ Р МЭК 61508-4-2012, статья 3.1.1] |

3.6 |

опасность (hazard): Потенциальный источник причинения вреда. [ГОСТ Р МЭК 61508-4-2012, статья 3.1.2] |

3.7 |

опасное событие (hazardous event): Событие, в результате которого может быть причинен вред. Примечание - Причинение вреда в результате опасного события зависит от того, подвергаются ли люди, имущество или окружающая среда воздействию последствий опасного события, и если причинение людям вреда возможно, то могут ли они избежать последствий события после того, как оно произошло. [ГОСТ Р МЭК 61508-4-2012, статья 3.1.4] |

3.8 |

система (system): Комбинация взаимодействующих элементов, организованных для достижения одной или нескольких поставленных целей. [Адаптировано из ГОСТ Р 57193-2016, пункт 4.1.44] |

3.9 |

систематический отказ (systematic failure): Отказ, связанный детерминированным образом с какой-либо причиной, которая может быть исключена только путем модификации проекта либо производственного процесса, операций, документации, либо других факторов. [ГОСТ Р МЭК 61508-4-2012, статья 3.6.6] |

3.10 |

система, связанная с безопасностью (safety-related system): Система, которая: - реализует необходимые функции безопасности, требующиеся для достижения и поддержки безопасного состояния УО, и - предназначена для достижения своими средствами или в сочетании с другими Э/Э/ПЭ системами, связанными с безопасностью, и другими средствами снижения риска необходимой полноты безопасности для требуемых функций безопасности. [Адаптировано из ГОСТ Р МЭК 61508-4-2012, статья 3.4.1] |

3.11 |

функция безопасности (safety function): Функция, реализуемая Э/Э/ПЭ системой, связанной с безопасностью, или другими мерами по снижению риска, предназначенная для достижения или поддержания безопасного состояния УО по отношению к конкретному опасному событию (3.7). [Адаптировано из ГОСТ Р МЭК 61508-4-2012, статья 3.5.1] |

3.12 |

управляемое оборудование; УО (equipment under control; EUC): Оборудование, машины, аппараты или установки, используемые для производства, обработки, транспортирования, в медицине или в других процессах. Примечание - "Системы управления УО" представляют собой отдельное, отличное от УО, понятие. [ГОСТ Р МЭК 61508-4-2012, статья 3.2.1] |

3.13 |

программируемая электроника; ПЭ (programmable electronic; PE): Средство, основанное на использовании компьютерных технологий и которое может включать в себя аппаратное и программное обеспечение, а также устройства ввода и/или вывода. Примечание - Данный термин охватывает микроэлектронные устройства, основанные на одном или нескольких центральных процессорах (ЦП) и связанных с ними устройствах памяти и т.п. Пример - К программируемым электронным устройствам относятся: - микропроцессоры; - микроконтроллеры; - программируемые контроллеры; - специализированные интегральные схемы; - программируемые логические контроллеры; - другие устройства на основе компьютерных технологий (например, микропроцессорные датчики, преобразователи, устройства привода). [ГОСТ Р МЭК 61508-4-2012, статья 3.2.12] |

3.14 |

электрический/электронный/программируемый электронный; Э/Э/ПЭ (electrical/electronic/ programmable electronic; Е/Е/РЕ): Основанный на электрической (Э), и/или электронной (Э), и/или программируемой электронной (ПЭ) технологии. Примечание - Данный термин предназначен для того, чтобы охватить любое или все устройства или системы, действующие на основе электричества. Пример - В число электрических/электронных/программируемых электронных устройств входят: - электромеханические устройства (электрические); - твердотельные непрограммируемые электронные устройства (электронные); - электронные устройства, основанные на компьютерных технологиях (программируемые электронные). [ГОСТ Р МЭК 61508-4-2012, статья 3.2.13] |

3.15 технология ИИ (Al technology): Технология, используемая для применения модели ИИ (3.16).

3.16 модель ИИ (Al model): Физическое, математическое или иное логическое представление системы, объекта, явления, процесса или данных.

Примечание - См. [2], пункт 3.1.23.

3.17 тестовый оракул (test oracle): Источник информации для определения успешности прохождения теста.

Примечание - См. [3], пункт 3.115.

4 Сокращения

В настоящем стандарте применены следующие сокращения:

ИИ | - искусственный интеллект; |

ИНС | - искусственная нейронная сеть; |

ИТ | - информационные технологии; |

КПЗ | - ключевой показатель эффективности; |

МО | - машинное обучение; |

ПО | - программное обеспечение; |

СНС | - сверточная нейронная сеть; |

CUDA | - архитектура унифицированного вычислительного устройства (compute unified device architecture); |

FMEA | - анализ видов и последствий отказов (failure modes and effects analysis); |

JPEG | - объединенная группа экспертов по фотографии (joint photographic experts group). |

5 Общие положения функциональной безопасности

5.1 Введение в функциональную безопасность

Сфера функциональной безопасности фокусируется на рисках, связанных с травмами и вредом для здоровья людей, окружающей среды и, в некоторых случаях, снижением вреда для продукции или оборудования. Определение риска различается в зависимости от области применения термина, см. раздел 3. Оба приведенных определения являются важными понятиями для использования ИИ. Все упоминания понятия "риск" далее в настоящем стандарте относятся к определению сточки зрения функциональной безопасности.

В соответствии с ГОСТ Р МЭК 61508-1 управление риском является итерационным процессом оценки и снижения риска. Оценка риска выявляет источник вреда и риски, связанные с целевым использованием и с разумно предсказуемым неправильным использованием продукта или системы. Снижение риска уменьшает риски до уровня, который становится допустимым. Допустимым риском считается такой уровень риска, который приемлем в заданном контексте при существующем уровне развития технологии.

Серия стандартов ГОСТ Р МЭК 61508 в качестве наилучшей практики устанавливает следующий подход, состоящий из трех стадий:

- стадия 1: функционально безопасный проект;

- стадия 2: ограничительные и защитные устройства;

- стадия 3: информация для конечного пользователя.

Снижение риска путем обеспечения функциональной безопасности относится к стадии 2.

Настоящий стандарт ограничивается рассмотрением аспектов функций безопасности, выполняемых системой, связанной с безопасностью, которая использует технологии ИИ, либо в рамках системы, связанной с безопасностью, либо в процессе проектирования и создания системы, связанной с безопасностью (стадия 2).

В настоящем стандарте не рассматривается методика использования технологии ИИ на стадиях 1 и 3.

5.2 Функциональная безопасность

ГОСТ Р МЭК 61508-4 определяет функциональную безопасность как "часть общей безопасности, обусловленную применением УО и системы управления УО и зависящую от правильности функционирования Э/Э/ПЭ систем, связанных с безопасностью, и других средств по снижению риска". Э/Э/ПЭ система, связанная с безопасностью, обеспечивает функцию безопасности, которая в ГОСТ Р МЭК 61508-4 определена как "функция, реализуемая Э/Э/ПЭ системой, связанной с безопасностью, или другими мерами по снижению риска, предназначенная для достижения или поддержания безопасного состояния УО по отношению к конкретному опасному событию". Иными словами, функции безопасности управляют риском, связанным с опасностью, которая может нанести вред людям или окружающей среде. Функции безопасности могут также снизить риск серьезных экономических последствий.

Как следует из термина, функциональная безопасность, как она определена по ГОСТ Р МЭК 61508-4, направлена на достижение и поддержание функционально безопасного состояния УО путем обеспечения функций безопасности. Исходя из включения в определение функциональной безопасности и функций безопасности формулировки "другие меры по снижению риска" нетехнические функции также явно учтены. Понятие УО не ограничивается отдельными устройствами, оно может быть также и системами.

В соответствии с приведенными определениями функциональная безопасность как сфера деятельности связана, таким образом, с надлежащим выстраиванием этих собственно технических и нетехнических функций безопасности для снижения риска или ограничения уровня риска для конкретного УО, начиная с уровня компонентов и заканчивая уровнем системы в целом, принимая во внимание человеческий фактор и учитывая условия эксплуатации и воздействие окружающей среды.

Функциональная безопасность сфокусирована на функциях безопасности для снижения риска и на свойствах этих функций, требуемых для снижения риска. Хотя функционал любой функции безопасности привязан к конкретному контексту ее использования, те свойства, которые требуются для снижения риска, и связанные с ними меры находятся в центре внимания при стандартизации функциональной безопасности.

До появления программируемых систем, когда функции безопасности были ограничены в применении аппаратными средствами, основной целью функциональной безопасности была минимизация последствий и вероятности случайных отказов оборудования. При все большей роли ПО в применении функций безопасности фокус внимания сдвинулся в сторону систематических отказов на этапах проектирования и создания.

Примечание - [4] описывает требования к безопасности для целевого функционала, включая такие аспекты, как ограничение характеристик. В приложении D приведено описание их интерпретации для МО.

Накоплена база знаний о том, как избежать систематических отказов в системах, не использующих ИИ, и при разработке ПО. Настоящий стандарт рассматривает использование ИИ в контексте функций безопасности. Функции, включающие технологии ИИ, особенно МО, обычно разрабатываются иначе, чем системы без ИИ. Они менее привязаны к спецификациям и в большей степени опираются на отслеживание данных, определяющих поведение системы. Именно поэтому каталог существующих мер предотвращения систематических отказов дополняется, принимая во внимание особенности технологий ИИ: в приложении А приведен пример такого дополнения. Меры по снижению рисков, характерные для ИИ, также отличаются от мер, применяемых для систем без ИИ, с функциональной точки зрения. Функциональная безопасность ставит во главу угла стойкость к систематическим отказам по ГОСТ Р МЭК 61508-4-2012 (статья 3.5.9) в дополнение к случайным отказам оборудования и систематическим отказам на протяжении всего жизненного цикла.

Предназначение технологии ИИ при реализации функции безопасности состоит в том, что они дают возможность обратиться к новым методам снижения риска. Настоящий стандарт посвящен исследованию применения технологии ИИ для этих целей, не пренебрегая существующими концепциями снижения риска, путем предложения некоторых положений, связанных с риском и классификацией.

В целом достижение приемлемого уровня риска для систем, уровень сложности и автоматизации которых все более возрастает, вероятно, связано с усовершенствованием концепций безопасности. Оно связано с адекватным применением как технических, так и иных мер снижения риска для достижения и поддержания системы в безопасном состоянии. Гарантировать валидность таких усовершенствованных концепций безопасности - большой вызов в области функциональной безопасности. Данный вызов приводит к возрастанию числа требований функциональной безопасности. Для всех технических мер снижения риска отличительной особенностью является учет случайных и систематических отказов оборудования, приведенных в серии стандартов ГОСТ Р МЭК 61508 и в стандартах, разработанных на их основе. Однако в случае функций безопасности на основе технологии ИИ неизбежно потребуется дополнительный фокус внимания на необходимости обеспечения гарантии в отношении того, что возможности систем, которые используют эти функции, достаточны для той среды, в которой они будут применяться.

6 Использование технологии ИИ в Э/Э/ПЭ системах, связанных с безопасностью

6.1 Постановка проблемы

Использование технологии и систем ИИ на момент разработки настоящего стандарта не описано ни в одном стандарте функциональной безопасности, а в некоторых стандартах их использование запрещено. Стандарты, в которых упоминается ИИ: [4], [5] и [6].

6.2 Технологии ИИ в Э/Э/ПЭ системах, связанных с безопасностью

Э/Э/ПЭ системы, связанные с безопасностью, имеют набор характеристик, которые надежно обеспечивают заданный уровень безопасности. В идеальном случае эти характеристики универсальны и не зависят от условий применения в конкретном случае. Однако данные и спецификации варьируются в зависимости от конкретного случая применения и сферы технологий. Процесс определения характеристик показан на рисунке 3 (см. 7.2) для каждой из трех стадий фреймворка ИИ. Характеристики могут определяться для каждого отдельного случая, относящегося к конкретному применению и сфере технологии, связанными с ними данными и спецификациями. Некоторые из этих характеристик могут быть основаны на таких стандартах, как ГОСТ IEC 61508-3, ГОСТ Р ИСО 26262-1, ГОСТ Р ИСО 26262-5, ГОСТ Р ИСО 26262-6, ГОСТ Р МЭК 61508-1, ГОСТ Р МЭК 61508-2, ГОСТ Р МЭК 61508-4, [7], [8], [9], [10]. Другие характеристики определены недавно. В разделе 8 приведен перечень типичных характеристик.

Соответствие заданным характеристикам требует выполнения конкретных требований функциональной безопасности при реализации, установке, валидации таких систем, а также при управлении ими и их техобслуживании. Например, ГОСТ IEC 61508-3 определяет требования для ПО Э/Э/ПЭ систем. Но некоторые технологии ИИ используют иные подходы на стадии создания системы (например, МО), чем те, которые использовались до применения ИИ в разработках, на которые распространяется ГОСТ IEC 61508-3.

Для рассмотрения отличий традиционных подходов разработчиков и подхода, типичного для использования ИИ, в настоящем подразделе приведена общая схема классификации, которая показывает применимость технологии ИИ для Э/Э/ПЭ систем, связанных с безопасностью, в разных контекстах применения технологии ИИ.

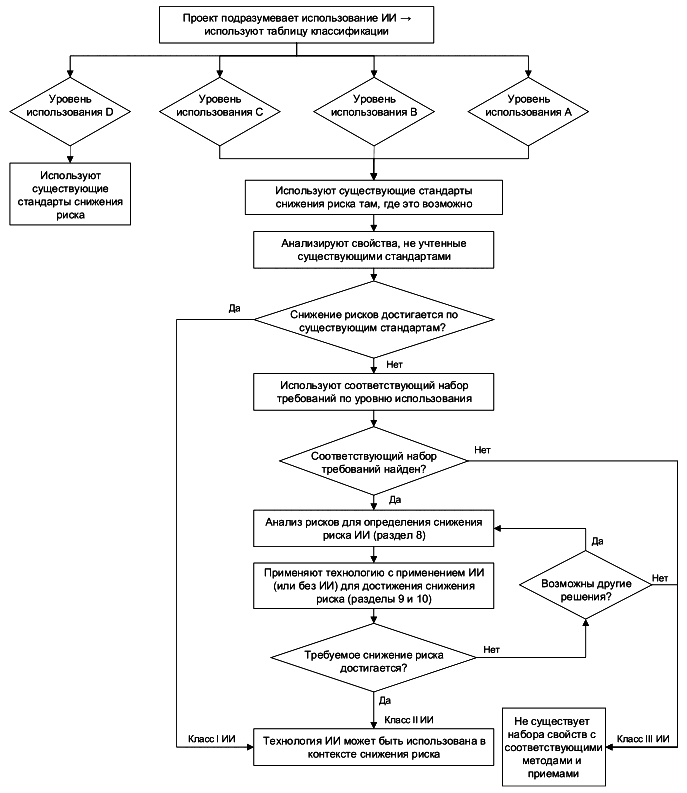

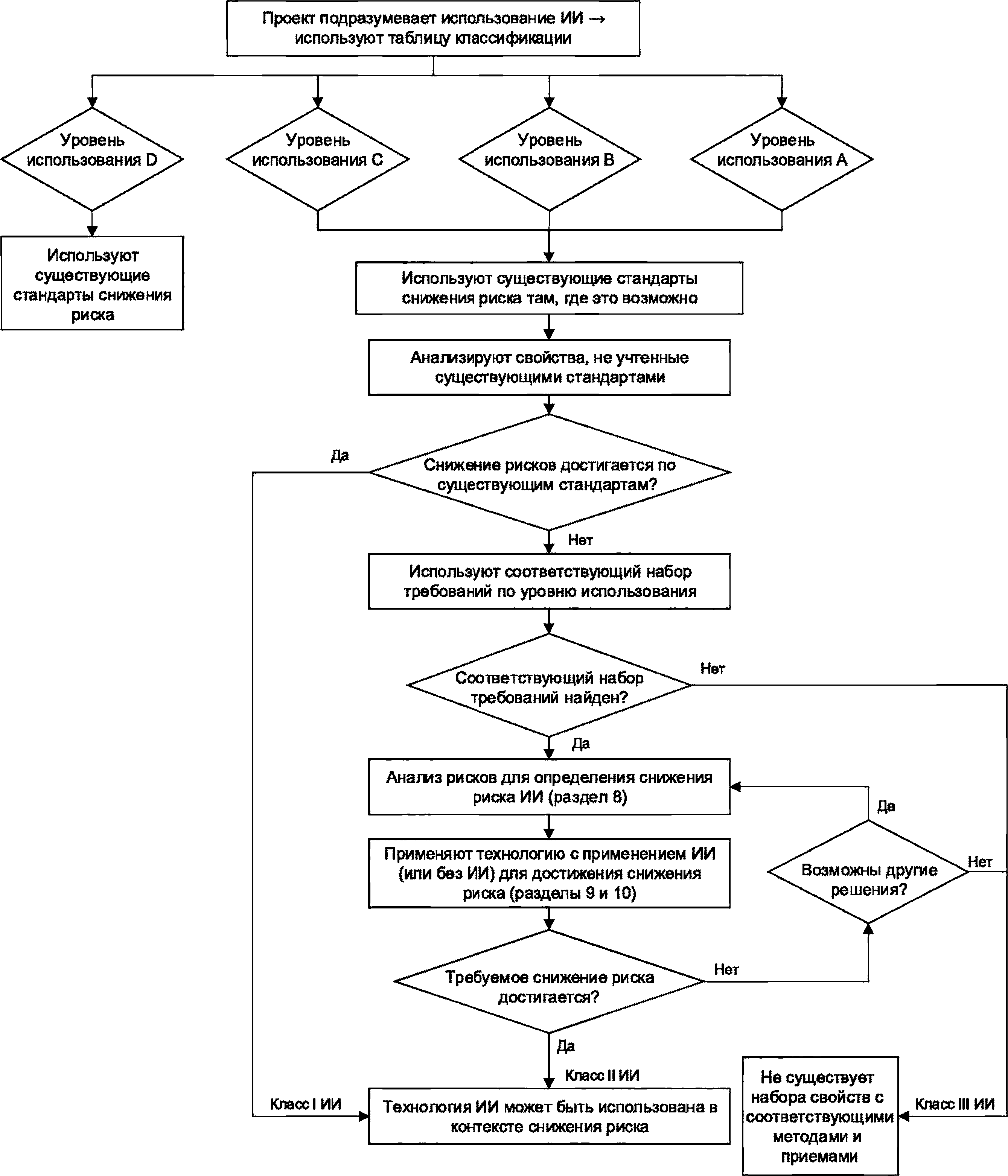

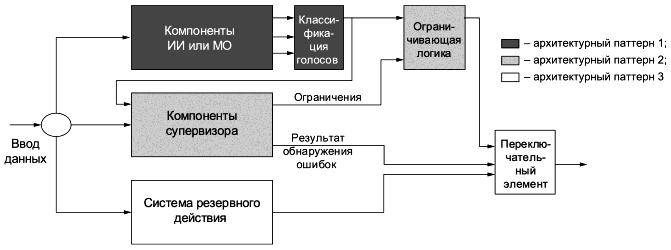

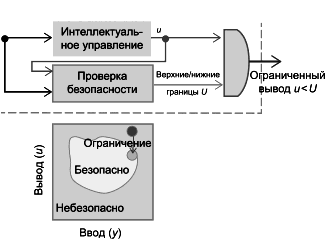

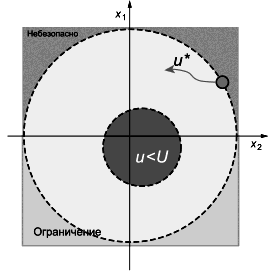

Пример схемы классификации приведен в таблице 1, а соответствующая блок-схема - на рисунке 1. На схеме показано, как именно технология ИИ может применяться в контексте функциональной безопасности для конкретного применения. Соответствующие отраслевые стандарты применяются для конкретизации общей схемы классификации в конкретные практические требования.

Схема классификации (таблица 1) организована согласно двум признакам:

1) Применение ИИ и уровень использования. Этот признак учитывает применение ИИ и способы его использования. Он классифицируется от A до D, с промежуточными уровнями для A и B.

Примечание - Факторы, приведенные в разделе 8, важны в контексте классификации. Они включают уровень автоматизации и управления (8.2), степень понятности и объяснимости (8.3), проблемы, связанные с окружающей средой (8.4), устойчивость к состязательным вводам данных и злонамеренному воздействию (8.5), проблемы аппаратных средств, связанные с применением ИИ (8.6), и зрелость технологии (8.7).

Пример классификации уровня использования:

- уровень использования A1 присваивается, когда технология ИИ используется в Э/Э/ПЭ системе, связанной с безопасностью, где возможно автоматическое принятие решения системной функции с использованием технологии ИИ;

- уровень использования A2 присваивается, когда технология ИИ используется в Э/Э/ПЭ системе, связанной с безопасностью, где невозможно автоматическое принятие решения системной функции с использованием технологии ИИ (например, ИИ используется в Э/Э/ПЭ системе для функции диагностики).

Примечание - Оценка может меняться в зависимости от роли функции диагностики, например от того, насколько диагностика критична для поддержания функциональной безопасности системы, или она является лишь одним из множества факторов функциональной безопасности наряду с другими;

- уровень использования B1 присваивается, когда технология ИИ используется только на стадии создания Э/Э/ПЭ системы, связанной с безопасностью (например, как вспомогательный инструмент вне сети), и возможно автоматическое принятие решения разработанной функцией с использованием технологии ИИ;

- уровень использования B2 присваивается, когда технология ИИ используется только на стадии создания Э/Э/ПЭ системы, связанной с безопасностью (например, как вспомогательный инструмент вне сети), и невозможно автоматическое принятие решения разработанной функцией;

- уровень использования C присваивается, когда технология ИИ не является частью функции функциональной безопасности в Э/Э/ПЭ системе, но может иметь опосредованное влияние на эту функцию.

Примечание - Уровень использования C относится к применению ИИ, которое явно обеспечивает дополнительное снижение риска, при этом его отказ не является критичным для уровня приемлемого риска.

Пример - Применение ИИ для увеличения или снижения объема потребления в системе безопасности;

- уровень использования D присваивается, когда технология ИИ не является частью функции функциональной безопасности в Э/Э/ПЭ системе и не может иметь влияния на эту функцию из-за ее отделения и управления состоянием.

Примечание - Примером может быть разделение через изолированную программную среду или гипервизор таким образом, чтобы исключить влияние на функционал безопасности.

2) Класс технологии ИИ. Этот признак связан с уровнем реализации технологии ИИ при удовлетворении определенному набору характеристик:

- класс I присваивается, если технология ИИ может быть создана и проверена на основе существующих стандартов функциональной безопасности, например если характеристики и набор методов и приемов для достижения этих характеристик могут быть определены на основе существующих стандартов функциональной безопасности;

- класс II присваивается, если технология ИИ не может быть полностью создана и проверена на основе существующих стандартов функциональной безопасности, но все-таки возможно (как показано на рисунке 1) определить дополнительные требования, методы и приемы для разработки, создания, верификации и валидации желаемых характеристик безопасности для достижения необходимого снижения риска;

- класс III присваивается, если технология ИИ не может быть создана и проверена на основе существующих стандартов функциональной безопасности и при этом также невозможно удовлетворить все заданные требования по характеристикам на основе соответствующих методов и приемов.

Компоненты, включающие технологию ИИ, состоят из разнообразных элементов (см. раздел 7). Каждый элемент может принадлежать к отдельному классу технологии ИИ. Например, нижние уровни абстракции в нейронной сети могут применять библиотеки C++, которые сами по себе могут систематически подвергаться проверке (например, в соответствии с ГОСТ IEC 61508-3), см. приложение A. Как таковые, они могут быть отнесены к классу I, хотя более высокие уровни абстракции (например, модели глубокого обучения) будут скорее отнесены к классу II или III.

Для компонентов ИИ класса I применение существующих стандартов функциональной безопасности возможно и в целом желательно. Для компонентов ИИ класса II применение существующих стандартов функциональной безопасности приведет к достижению характеристик, требуемых для функциональной безопасности, только частично.

После этого к оставшимся параметрам применяются дополнительные методы и приемы, такие как дополнительная верификация и валидация (см. раздел 9). Эффективность дополнительных методов и приемов может быть различной для разных приложений и уровней использования. Для компонентов ИИ класса III на момент разработки настоящего стандарта не существует известных методов и приемов для идентификации набора характеристик, которые обеспечивают существенное снижение риска.

Примечание - Приведение подробного руководства по эффективности применения дополнительных методов и приемов для каждого приложения и уровня использования не является целью настоящего стандарта.

Таблица 1 - Пример таблицы классификации ИИ

Класс технологии ИИ Применение и уровень использования ИИ | Класс I технологии ИИ | Класс II технологии ИИ | Класс III технологии ИИ |

Уровень использования A1 | Возможно применение концепций снижения риска на основе | Соответствующий набор требований | На момент разработки настоящего стандарта не было известно о |

Уровень использования A2 | существующих стандартов функциональной | Соответствующий набор требований | существовании подходящего набора свойств с |

Уровень использования B1 | безопасности | Соответствующий набор требований | соответствующими методами и приемами, обеспечивающими |

Уровень использования B2 | Соответствующий набор требований | существенное снижение риска | |

Уровень использования C | Соответствующий набор требований | ||

Уровень использования D | Нет конкретных требований по функциональной безопасности для технологии ИИ, но применяются концепции снижения риска из существующих стандартов функциональной безопасности | ||

Статическое (вне сети) обучение на стадии создания. Динамическое (в сети) обучение возможно. Соответствующий набор требований для каждого уровня использования может определяться путем применения концепций снижения риска в соответствии с существующими стандартами функциональной безопасности и дополнительных факторов, приведенных в разделах 8-11. Примеры приведены в приложении B. Определение детальных требований для каждого уровня использования не является задачей настоящего стандарта. | |||

|

Рисунок 1 - Блок-схема для определения классификации технологий ИИ

7 Элементы технологии ИИ и принцип трех стадий ее реализации

7.1 Элементы технологии для создания и выполнения моделей ИИ

Создание и выполнение модели ИИ охватывает разные элементы технологии ИИ. В таблице 2 приведено высокоуровневое описание систем ИИ и задействованных типичных элементов исходя из функциональных слоев экосистемы ИИ в соответствии с [2], рисунок 6.

Таблица 2 - Элементы технологии ИИ [2]

Элемент технологии ИИ |

Интеллектуальные службы |

МО: - создание модели и ее использование; - инструменты; - данные для МО |

Проектирование: - знания из практического опыта в специальной области; - инструменты |

Облачные и периферийные вычисления, большие данные, источники данных |

Пул ресурсов - обработка, хранение, создание сети |

Управление ресурсами - обеспечение доступа к ресурсам |

К некоторым элементам технологии можно применить существующие концепции функциональной безопасности (например, программы, компилирующие модель в исполняемую программу). Однако все элементы технологии, участвующие в создании и выполнении модели, могут иметь отношение к соображениям безопасности, включая те, к которым можно применить существующие концепции функциональной безопасности, и те, для которых могут быть определены новые концепции. В приложении А приведен пример того, как существующие концепции функциональной безопасности могут применяться к технологии ИИ путем оценки применимости ГОСТ IEC 61508-3. В приложении В приведен пример того, как конкретные характеристики, такие как описанные в разделе 8, могут применяться к технологии ИИ, для которой существующие концепции функциональной безопасности применить невозможно.

Как показано на рисунке 2, элементы, включающие технологии ИИ, используются на разных уровнях системы или приложения:

- для элементов высокого уровня (граф приложения, модель МО и связанные с ними инструменты) могут быть применимы специфические характеристики, приведенные в разделе 8;

- для элементов более низкого уровня (программы в машинном коде и подобные элементы) применимы характеристики, не связанные с ИИ, приведенные в существующих стандартах, например ГОСТ IEC 61508-3, ГОСТ Р ИСО 26262-1, ГОСТ Р ИСО 26262-5, ГОСТ Р ИСО 26262-6, ГОСТ Р МЭК 61508-1, ГОСТ Р МЭК 61508-2, ГОСТ Р МЭК 61508-4, [9].

|

Рисунок 2 - Иерархия элементов технологии (на примере МО)

7.2 Трехступенчатый принцип реализации системы ИИ

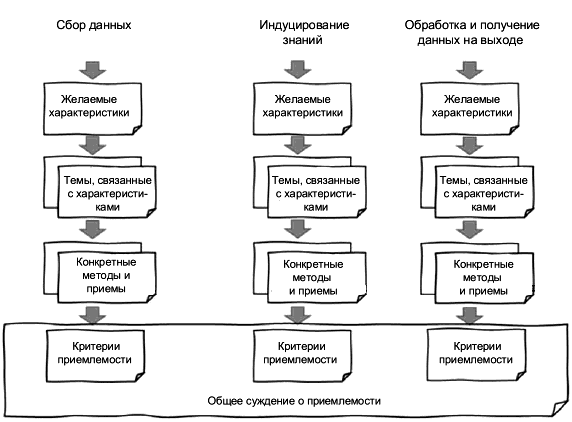

Любая система ИИ может быть представлена (см. рисунок 3) на основе принципа реализации в трех стадиях:

- сбор данных;

- индуцирование знаний из данных и человеческого знания;

- обработка и получение данных на выходе.

Примечания

1 В соответствии с [2], рисунок 5, первая стадия связана с задачей ввода, вторая - с задачей обучения, третья - с задачей обработки данных.

2 В данном контексте, человеческое знание получается из самых разных источников, как в соответствующих сферах деятельности, так и в системах ИИ.

3 Предложенный принцип реализации является общим. Специфические более детальные примеры систем ИИ: отслеживание - анализ - план - исполнение (МАРЕ), ощущение - понимание - решение - действие (SUDA).

4 Цель трехступенчатого принципа реализации - не описание жизненного цикла (который описан в разделе 11 и включает все стадии: от разработки концепции и ее созревания до разработки требований), а демонстрация другой точки зрения.

5 Рисунок 3 не показывает петли обратной связи, которые могут быть применимы к системам ИИ, встроенным в контуры принятия решений или влияющим на ситуацию в реальном мире.

6 Индукция знаний включает обучение модели, в то время как обработка информации включает логический вывод.

|

Рисунок 3 - Трехступенчатый принцип реализации

7.3 Вывод критериев приемлемости для трех стадий принципа реализации

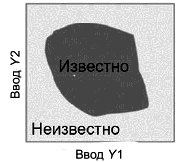

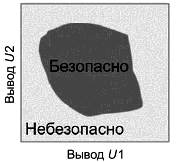

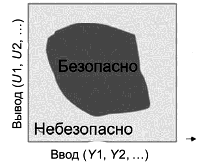

Следующий процесс (см. рисунок 4) может быть применен для получения критериев приемлемости на основе трехступенчатого принципа реализации:

- желаемые характеристики определяются для каждой из трех стадий;

- характеристики связываются с темами и с конкретными методами и приемами, применимыми для этих тем;

- критерии приемлемости получаются из набора конкретных методов и приемов. Как показано на рисунке 4, критерии для приемлемости выбранных методов и приемов и, возможно, показателей и пороговых значений, таких как пределы оцениваемых неопределенностей, встроены в общее суждение о приемлемости. Общее суждение о приемлемости показывает, что выбранные критерии приемлемости гармонизированы с независимыми от технологии критериями приемлемости риска, такими как ALARP, MEM, GAMAB или PRB. Общее суждение о приемлемости может быть представлено, например, для гарантийного случая.

|

Рисунок 4 - Процессы на каждом этапе

Примечания

1 Характеристики могут определяться для каждого отдельного случая или выводиться из тех, которые указаны в существующих стандартах, в зависимости от уровня элементов, использующих технологию ИИ. В разделе 8 представлен список рассматриваемых характеристик.

2 "Желаемые характеристики", "темы, относящиеся к характеристикам" и "конкретные методы и приемы" могут быть индивидуальными для каждого этапа или общими, в зависимости от конкретного применения.

3 В данном контексте критерии приемлемости рассматриваются как то, что может быть выявлено и подтверждено в процессе разработки.

8 Характеристики систем ИИ и связанные с ними факторы риска

8.1 Введение

8.1.1 Общие положения

В разделе 7 описано, каким образом определение искомых характеристик становится первым этапом трехступенчатого принципа реализации. Характеристики привязаны к темам и в конечном счете к конкретным методам и приемам, применяемым для этих тем. Критерии приемлемости выделяются на основе конкретных методов и приемов.

Настоящий раздел является руководством, посвященным характеристикам, которые описывают системы, использующие технологии ИИ, и связанные с ними факторы риска. Такие характеристики и факторы риска включают уровень автоматизации и контроля (см. 8.2), степень понятности и объяснимости (см. 8.3), проблемы, связанные с окружающей средой (см. 8.4), устойчивость к состязательным вводам данных и злонамеренному воздействию (см. 8.5), проблемы аппаратных средств, связанные с применением ИИ (см. 8.6) и зрелость технологии (см. 8.7).

Характеристики систем, использующих технологию ИИ, и факторы риска подробно описаны в настоящем разделе.

8.1.2 Алгоритмы и модели

На технологическом уровне функциональные возможности ИИ часто определяются сочетанием модели ИИ и параметров этой модели. Параметры, которые генерирует алгоритм в процессе обучения, обычно отражают ту информацию, которая соответствует цели применения (например, как разные входные данные нужно различать и распознавать), в то время как модель вычисляет информацию на основе параметров и входных данных (например, для прогнозирования). Это значит, что функциональная безопасность приложения зависит и от того, и от другого.

Приведенные примеры типов моделей ИИ включают линейные функции, логические исчисления, динамические байесовские сети и ИНC. Параметры моделей могут быть установлены "вручную" инженером или синтезированы на основе данных с помощью алгоритмов МО, которые сами используют процесс систематического анализа. Модели обычно внедряются в виде, готовом к исполнению, в таком, как машинный код (для ПО) или специальные аппаратные средства, такие как программируемая пользователем вентильная матрица (field programmable gate arrays, FPGA).

Обычно модели сами по себе, без параметров, содержат ограниченный объем знаний или импликаций о предназначении приложения. Это примерно то же, что библиотеки базовых программ или программная среда (компиляторы и т.п.), используемые в ПО, не связанном с использованием ИИ. Правильное функционирование модели критически важно для обеспечения функциональной безопасности. Таким образом, целостность реализаций модели в сфере ИИ часто может регулироваться с помощью существующих принципов функциональной безопасности, приведенных, например, в ГОСТ IEC 61508-3, ГОСТ Р МЭК 61508-1, ГОСТ Р МЭК 61508-2, ГОСТ Р МЭК 61508-4, точно так же, как это происходит в случае программных компонентов, не использующих ИИ. То же применимо и к логике, задействованной в подготовке моделей, и параметров к исполнению.

В противоположность вышесказанному, параметры модели часто содержат знания о цели применения систем, связанных с функциональной безопасностью. Существует несколько разных способов конструирования параметров и могут использоваться разные подходы к оценке полноты мер по снижению риска для обеспечения функциональной безопасности.

Например, если параметры модели создаются вручную инженерами, модели с большой вероятностью отражают знания инженеров о приложении, которое может быть оценено в процессе управления в рамках жизненного цикла функциональной безопасности. В таком случае можно использовать жизненный цикл из существующих стандартов (технология ИИ класса I - по 6.2). Часто можно легко создать параметры вручную для простых моделей, таких как простые линейные функции или логические исчисления.

В отдельных случаях параметры, полученные из данных с помощью алгоритмов МО, можно проанализировать и верифицировать после их получения. В других случаях параметры, полученные с помощью алгоритмов МО, можно извлечь и использовать их затем для обогащения знаний, которые могут использоваться, в свою очередь, для развития технологии ИИ в дальнейшем. При применении валидированного инженерного знания также может использоваться жизненный цикл из существующих стандартов функциональной безопасности (например, можно рассматривать эти модели как технологию ИИ класса I - по 6.2).

В других случаях параметры, полученные с помощью алгоритмов МО, могут быть слишком сложными для понимания, анализа и верификации. Это относится к сложным типам моделей, таким как нейросети, потому что представления моделей в этих случаях не всегда отражают человеческое понимание и способ рассуждения. Применение других подходов к оценке снижения риска для функциональной безопасности оправдано в таких случаях, и это может оказаться огромной проблемой при использовании технологии ИИ для создания систем функциональной безопасности.

8.2 Уровень автоматизации и контроля

Уровень автоматизации (называемый иногда "степень независимости") отражает степень, до которой система ИИ функционирует независимо, без надзора и управления со стороны человека. Эта характеристика определяет не только объем информации о системе, доступный оператору, но и варианты управляющих действий и вмешательства со стороны человека.

В рамках данной темы рассматривается вопрос о том, насколько высок уровень автоматизации для конкретного приложения, а также степень ограничения пользователя в выборе управляющих действий. Системы, использующие технологии ИИ с высокой степенью автоматизации, могут демонстрировать неожиданное поведение, которое трудно заметить и проконтролировать. Поэтому применение высокоавтоматизированных систем представляет некоторый риск с точки зрения характеристик их функционирования, таких как надежность и безопасность.

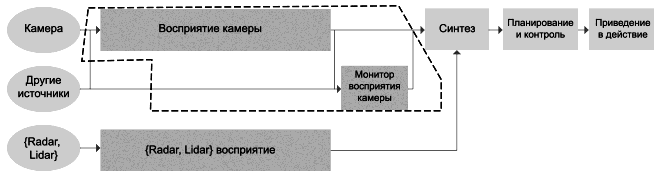

При рассмотрении вопроса о том, достигнута ли функциональная безопасность, важны несколько аспектов, например оперативность системы ИИ и наличие или отсутствие "супервизора". В данном случае "супервизор" служит для валидации и одобрения автоматических решений, принятых системой. Такой "супервизор" может быть технической управляющей функцией, хотя в некоторых случаях такая супервизорная функция не может применяться, например в случае очень сложных решений или для систем с МО, которые научились чему-то новому. Например, вторая система, оснащенная инструментами безопасности, может быть добавлена для критически важных управляющих действий, она придана функции безопасности для резервных компонентов в соответствии со стандартами функциональной безопасности, например ГОСТ Р МЭК 61508-1.

Другой способ использования "супервизора" - вмешательство человека в критической ситуации или подтверждение человеком решений системы. Один из способов - добавить систему (уровень использования C или D - по 6.2), чтобы помочь человеку-супервизору заметить возможные последствия принятия решения. Примером может быть система моделирования, которая дает информацию по принципу "что, если..." для разных решений и может проверить последствия. Но даже если человек включен в контур и наблюдает за действиями системы, иногда это не может снизить риски до приемлемого уровня, а может даже привести к дополнительным рискам.

Пример - Водитель не замечает гололеда на дороге и может взять на себя управление автомобилем, не понимая, почему автопилот ведет машину так осторожно.

Адаптивность системы ИИ также является фактором, особенно сточки зрения изменения поведения системы во времени, как это происходит в системах на МО. Такие системы могут адаптироваться к изменению окружающей среды (например, через петлю обратной связи или с помощью функции оценки качества) и могут постепенно демонстрировать даже совершенно новые функции. Недостаток таких обучаемых систем состоит в том, что они могут отходить от изначальных спецификаций и поэтому трудно поддаваться валидации. По этой причине следует очень тщательно взвешивать решение о применении таких систем на более высоких уровнях использования A-C - по 6.2.

В таблице 3 ([2], таблица 1) приведены термины и понятия, связанные с уровнем автоматизации.

Таблица 3 - Соотношение автономии, гетерономии и автоматизации ([2], таблица 1)

Объект | Вид | Уровень автоматизации | Описание |

Автоматизированная система | Автономная | Автономность | Система способна модифицировать сферу своей работы или свои цели без вмешательства извне, без контроля и надзора |

Гетерономная | Полная автоматизация | Система может выполнить поставленную задачу до конца без вмешательства извне | |

Высокая автоматизация | Система частично выполняет поставленные задачи без вмешательства извне | ||

Автоматизация обусловленная | Выполнение конкретных задач с высокой надежностью при наличии внешнего агента, готового взять на себя управление при необходимости | ||

Частичная автоматизация | Некоторые подфункции системы полностью автоматизированы, но система в целом находится под управлением внешнего агента | ||

Ассистирование | Система является ассистентом оператора | ||

Отсутствие автоматизации | Оператор полностью управляет системой |

Примечание - Разделение на уровни относится к функциям автоматизации управления в любых реализациях автоматизированной системы ИИ, учитываются функции компонентов этой системы (например, бортовое оборудование, напольное оборудование и оборудование диспетчерской в системах управления на железной дороге).

8.3 Степень понятности и объяснимости

Часто аспекты понятности и объяснимости объединяются под термином "понятность". Но эти термины следует различать.

В [2], 5.15.6, объяснимость определяется как свойство системы ИИ отражать важные показатели, влияющие на результаты системы ИИ, в виде, понятном для людей, при этом понятность по ГОСТ Р 59276-2020 (статья 3.10) определяется как свойство системы ИИ, заключающееся в возможности открытого, исчерпывающего, доступного, четкого и понятного представления информации заинтересованным лицам о внутренних процессах в системе ИИ.

В частности, информация о модели, лежащей в основе процесса принятия решений, вероятно, будет актуальной. Использование систем с низкой понятностью может представлять риск сточки зрения несмещенности, защищенности и подконтрольности решений. Более того, оценка качества таких систем может быть затруднена. С другой стороны, высокая степень понятности может приводить к некоторой путанице из-за информационной перегрузки или может приводить к конфликтным ситуациям в сфере защиты личных данных, защищенности системы, конфиденциальности или охраны прав интеллектуальной собственности. Желаемый уровень объяснимости может часто быть достигнут без высокого уровня понятности. Поэтому важно найти надлежащий уровень понятности, чтобы разработчики могли идентифицировать и исправлять ошибки в системе, обеспечив при этом доверие к системе со стороны пользователя.

При программировании без использования ИИ намерения и знания программиста обычно закодированы с помощью процесса логического вывода, и можно проследить через код, как и почему определенное решение было принято программой. Это можно сделать либо через обратное отслеживание и отладку программы, либо путем обратной инженерии. В отличие от таких систем решения, принимаемые моделями ИИ, особенно сверхсложными или полученными с помощью алгоритмов МО, оказываются гораздо менее понятными для человека. Способы кодирования знаний в структуре модели и способы принятия решений часто совершенно отличаются от того, как человек рассуждает в процессе принятия решения.

Высокий уровень объяснимости предотвращает непредсказуемое поведение системы, но иногда ему сопутствует низкий уровень функционирования системы в целом сточки зрения качества решений из-за ограничений существующей технологии объяснимости (она ограничивает объем информации в модели, чтобы иметь возможность интерпретации вывода). В данном случае выбор часто приходится делать между объяснимостью и функционированием системы в целом. Кроме того, важным фактором может быть актуальность информации о процессе принятия решений в системе ИИ. Может оказаться, что система выдает ясную и понятную информацию о своем процессе принятия решений, но эта информация неточная и неполная.

Объяснимый ИИ может также использоваться как помощник при анализе данных после события, потребовавшего вмешательства оператора, когда данные на входе, иногда транзитные, записываются и воспроизводятся.

Следовательно, желательно включать оценку понятности и объяснимости в общую оценку системы ИИ. При этом следует принимать во внимание следующее:

- достаточно ли доступна информация о системе;

- понятна ли система или выдает ли она информацию в понятном виде (возможно, косвенным образом) заданному получателю (получатель объяснений может быть разным, в зависимости от контекста: разработчик системы, первые пользователи системы или, в некоторых случаях, посторонние люди);

- выдает ли система правильные, полные и воспроизводимые результаты без сбоев;

- является ли полученное от системы адекватным требуемой степени доверия.

Существуют несколько концепций и стратегий оценки понятности и объяснимости, например приведенные в [11]. Кроме того, эмпирическая оценка процесса принятия решений для сложных моделей может происходить, например, путем анализа сверточной нейрононной сети через визуализацию компонентов ее внутренних слоев. Цель - сделать процесс принятия решения в сети более объяснимым путем наблюдения за тем, как особенности данных на входе влияют на полученный моделью вывод. Анализ информации на выходе СНС может выполняться путем инспектирования ее внутреннего состояния экспертом. Даже если доступ к данным о внутреннем состоянии модели невозможен, подходы, подобные рандомизированной выборке входных значений для (randomized input sampling for explanation, RISE), могут дать некоторое понимание для некоторых видов сетей.

Даже системы, которые традиционно считаются удовлетворительно объяснимыми путем визуального анализа (например, дерево решений), могут быстро стать настолько сложными, что не поддаются пониманию, если эти системы применяются в реальном мире. В ситуациях, когда нужно получить результат, поддающийся интерпретации, можно применить такие инструменты, как деревья оптимальной классификации или методы дистилляции ансамблей деревьев для снижения сложности и создания условий для инспекции экспертом.

Вообще говоря, даже если полностью объяснимый ИИ недостижим в настоящее время (подобный классу II технологии ИИ), методичное задокументированное оценивание возможности интерпретации модели может быть применено с точки зрения риска при тщательной оценке последствий для угрозы функциональной безопасности в случае ненадлежащих решений. Это помогает сравнить и выбрать модель и может прояснить ситуацию при анализе отказа после события.

8.4 Проблемы, связанные с окружающей средой

8.4.1 Сложность внешней среды и неопределенность спецификаций систем

Системы ИИ часто используются в такой среде, сложность которой не позволяет человеку провести ее анализ и описать ее. Технология ИИ может автоматически генерировать правила или применять суждения, не полагаясь на созданные человеком представления аналитических, подробных и сложных условий окружающей среды. Далее жизненный цикл разработки систем ИИ может начинаться при неопределенных спецификациях и неопределенных целях. Такие спецификации могут быть заданы в форме функциональных или нефункциональных требований.

Неопределенность спецификаций может привести к трудностям при утверждении функциональных характеристик, связанных с безопасностью. Сложность среды только ухудшает ситуацию. Даже определение допустимого уровня функциональной безопасности может быть невозможным из-за неточных спецификаций, поскольку определение функции безопасности зависит от заданной спецификации.

Для приложений функциональной безопасности важно пояснение функциональной полноты (см. ГОСТ Р ИСО/МЭК 25010). Вопросы функциональной полноты могут решаться с помощью подробной спецификации или при полном покрытии всей сложной среды (например, данными для обучения), или сочетая эти два подхода. Рекомендации приведены в 9.3.

Еще одна особенность сложности систем ИИ заключается в том, что, хотя их модели часто детерминированы, их выходные данные могут казаться вероятностными. Например, если взять очень сложную среду, которая может быть представлена большим пространством состояний и при этом среда постоянно изменяется и расширяется, может быть сложно гарантировать, что модель, которая хорошо обобщает поведение при конечном числе состояний, сможет реагировать надлежащим образом на каждое возможное состояние среды.

Эффект функционирования в сложной и не до конца определенной среде может привести к новому типу неопределенности, который находится за пределами существующих оценок функциональной безопасности.

Степень демонстрации адекватности моделей для целевого приложения является важным фактором. Кроме того, важно, что неопределенность модели из-за возможности некорректных прогнозов или неверных вычислений рассматривается с точки зрения планирования поведения и функционала.

Чтобы применить стохастическую концепцию к операционной среде, расширение стохастических допущений, обычно используемых в области функциональной безопасности для случайных отказов оборудования и "проверенных на практике" программных средств, является относительно новым подходом, который также может быть применим к технологиям ИИ, см. 10.2.5.

8.4.2 Проблемы, связанные с изменением среды

8.4.2.1 Дрейф данных

Дрейф данных - явление, связанное с тем, что распределение входных данных в бизнес-процессе отличается от использованного при обучении, что приводит к ухудшению функционирования модели, включая и безопасность. Дрейф данных часто связан с неполным представлением области допустимых значений входных данных во время обучения. Это явление может объясняться отсутствием учета сезонных изменений в данных на входе, непредвиденным вводом данных операторами или добавлением новых сенсорных устройств, которые появились в качестве источника вводимой информации.

Компоненты, включающие технологию ИИ, могут инспектироваться для обнаружения источников дрейфа данных в контексте анализа рисков и надлежащие меры могут планироваться в случае необходимости.

Некоторые случаи дрейфа данных могут быть отнесены к неверному выбору данных при создании модели. Типичными примерами являются выбор неподходящих данных при обучении модели, таких, где распределение данных на обучении не отражает истинное, наблюдаемое в контексте применения распределение данных, или пропуск важных примеров в данных для обучения. Такие проблемы могут исправляться с помощью улучшения данных на входе и переобучения.

Дрейф данных может быть вызван внешними факторами, например сезонными изменениями или изменениями в процессе, который способствует дрейфу. Примеры включают замену сенсора новым, который имеет новое напряжение смещения, или сенсор воспринимает разницу в условиях освещения при обучении и в данных, которые раньше не получал. Может быть целесообразно дать модели возможность справиться с дрейфом данных уже после ее развертывания, когда дообучение недоступно. В таких случаях модель создается таким образом, чтобы она оценивала факторы коррекции исходя из особенностей данных на входе или позволяла коррекцию супервизором.

Устройство модели должно позволять получение безопасных данных на выходе даже при вводе на вход никогда не вводимых ранее данных. Важно понимать, что использование надлежащих практик создания модели, например создание достаточно разнообразного набора обучающих данных, не снижает важности тщательного анализа для ответа на вопрос, может ли полученная в результате модель быть обобщена на данные в промышленной среде. Кроме того, если модель выдает небезопасные данные на выходе, важно провести тщательный анализ причин получения небезопасных данных на выходе и определить способ выхода системы из опасного состояния.

8.4.2.2 Изменение закономерности

Изменение закономерности означает изменение соотношения между переменными на входе и данными на выходе модели, она может сопровождаться изменениями в распределении вводимых данных. Например, данные на выходе могут использоваться для отслеживания приемлемого минимального расстояния оператора исходя из данных расстояния, полученных сенсором времени полета (данные на входе). Если принятые пороги безопасности изменяются под влиянием внешних факторов (например, возросшая скорость машины, не учтенная в модели), то произойдет изменение закономерностей, хотя и процесс, и данные на входе остались неизменными.

Системы в идеале имеют встроенные формы обнаружения дрейфа, отличая дрейф от шума в системе и адаптируясь к изменениям со временем. Потенциальные подходы включают модели, подобные методу раннего обнаружения дрейфа (early drift detection method, EDDM), обнаруживающие дрейф методом опорных векторов или отслеживающие ошибки логического вывода в процессе обучения с поправкой на обнаружение дрейфа и потенциальную адаптацию. Обнаружение дрейфа подразумевает некоторую форму мониторинга рабочего цикла и обновления модели, которые могут вносить рекомендуемые изменения в структуру и безопасность системы на уровне ПО или системы в целом (например, знать, когда функционально безопасно можно провести обновление, отслеживать неудавшиеся обновления).

Обработка изменений закономерностей часто происходит путем отбора подмножеств имеющихся обучающих данных или путем присвоения весовых коэффициентов отдельным обучающим объектам и затем переобучения модели.

8.4.3 Проблемы обучения на данных из внешней среды

8.4.3.1 Алгоритмы избыточной подстройки под вознаграждение

Алгоритмами избыточной подстройки под вознаграждение называют методы, когда ИИ находит способ "обыграть" свою функцию вознаграждения и найти "оптимальное" решение поставленной задачи. Это решение, хотя и более оптимальное в математическом смысле, нарушает допущения и ограничения в заданном сценарии в реальном мире. Например, система ИИ обнаруживает людей с помощью камеры и может решить, что получит большое вознаграждение в процессе обучения, если будет постоянно обнаруживать людей и отслеживать их с помощью своих сенсоров, при этом, возможно, не замечая критически важных событий на других участках. Такая тенденция может быть пресечена с помощью функций состязательного вознаграждения через независимую систему, которая может верифицировать полученные значения вознаграждения со стороны первичной функции, использующей технологии ИИ, и впоследствии обучится и адаптируется, чтобы противостоять первичной системе. Другая опция - предварительно обучить несвязанную функцию вознаграждения на основе только желаемого результата, без прямой связи с первичной функцией.

8.4.3.2 Безопасное исследование

Безопасное исследование представляет собой задачу, когда требования безопасности должны быть принудительно установлены во время сбора данных и обучения, что ограничивает разнообразие данных, которые получала модель на этапе обучения. Проблема безопасного исследования особенно остра, если агент имеет возможность исследовать среду и изменять ее. Это является проблемой не только, например, для сервисных роботов, беспилотных летательных аппаратов и других физических объектов, но и для программных агентов, использующих обучение с подкреплением для исследования своего рабочего пространства. В этих контекстах исследования пространства обычно подкрепляются вознаграждением, поскольку дают системе новые возможности для обучения. Очевидно, что самообучающаяся система должна следовать соответствующим протоколам функциональной безопасности в процессе исследования. Система, которая управляет параметрами бизнес-процесса и использует функцию случайного исследования среды, при этом не будучи отсоединена от самого бизнес-процесса, может представлять большую опасность.

8.5 Устойчивость к состязательным вводам данных и злонамеренному воздействию

8.5.1 Введение

При оценке надежности системы ИИ, важно определить целостность реакции функциональной безопасности на вредоносные атаки и злонамеренные воздействия.

В целом можно выделить в сфере ИИ два типа воздействия, направленного на возможный сбой в системе. Первый тип - те входящие данные, которые разрушают целостность выполнения программы (например, переполнение буфера или целочисленное переполнение), второй тип - те, которые заставляют модели ИИ вычислять неверный вывод без сбоев на уровне программы. Для решения первого типа проблем следует рассмотреть традиционные для ИТ требования безопасности, установленные в ГОСТ Р ИСО/МЭК 18045, ГОСТ Р ИСО/МЭК ТО 19791, ГОСТ Р ИСО/МЭК 21001, ГОСТ Р МЭК 62443-2-1 и ГОСТ Р МЭК 62443-3-3. Приведенные стандарты описывают процессы аудита и сертификации единых требований к безопасности в сфере ИТ, которые могут применяться и к системам ИИ и не обсуждаются далее в настоящем стандарте. Однако для решения второго типа проблем недостаточно использования лучших практических подходов и следования нормам стандартов для систем, не использующих ИИ. В 8.5.3 приведено описание второго типа проблем, влияющих на работу системы, с примерами состязательности естественного происхождения.

Примечания

1 Настоящий стандарт ограничивается достижением функциональной безопасности даже в присутствии направленной на ИИ угрозы безопасности. В нем не описывается, каким образом злонамеренное действие, возникающее по причине угрозы кибербезопасности, может быть пресечено. Меры, направленные на обеспечение целостности функциональной безопасности, важны, если разумно предсказуемая киберугроза может повлиять на функциональную безопасность.

2 Характеристики, обеспечивающие отсутствие злонамеренных вводных данных, могут противоречить тем, которые гарантируют характеристики функциональной безопасности.

3 Характеристики, обеспечивающие устойчивость к состязательным атакам, могут противоречить тем, которые гарантируют характеристики функциональной безопасности. Это рассматривается как фактор высшего уровня системной пригодности.

8.5.2 Общие защитные меры

В соответствии с надлежащими предосторожностями в сфере функциональной безопасности в качестве первого шага, обеспечивающего функционально безопасную работу, предлагается применение функций контроля, которые берут на себя управление системой в случае обнаружения проблемы в области функциональной безопасности, таким образом обеспечивается отсутствие вреда со стороны системы ИИ.

Для систем, требующих высокого уровня функциональной безопасности, требуется повышенное внимание как к случайным отказам, так и к систематическим ошибкам. В целом отказы и ошибки устраняются в соответствии с лучшими практиками (например, путем повышения защиты, робастности, тестирования и верификации). Кроме того, специальные меры противодействия в области МО важны для дальнейшего снижения рисков, связанных с дополнительными видами отказов и ошибок, свойственных технологии ИИ.

8.5.3 Атаки на модель ИИ: состязательное МО

Модели систем ИИ, особенно наиболее сложные из них, например нейронные сети, могут иметь особые слабые места, несвойственные другим типам систем. Необходимо рассмотреть их дополнительно, особенно в контексте функциональной безопасности. Примеры специфичных для моделей проблем включают состязательное МО и др.

Состязательное МО - это один из типов атаки на системы ИИ, который привлекает большой интерес в последнее время. Часто становится возможно обмануть модель ИИ и заставить ее выдавать абсолютно разные результаты путем небольших возмущений на входе, которые создаются с помощью процесса оптимизации. Если вводятся изображения, эти возмущения незаметны в целом для человека и могут хорошо маскироваться и в цифровых данных на входе. Хотя эти возмущения обычно не случайные, нельзя исключать, что аппаратные отказы и системный шум, уже присутствующие во входных данных, вызывают существенный сдвиг в данных на выходе. Интересно то, что состязательные примеры обычно хорошо воспроизводятся в моделях разной архитектуры и ее внутренних компонентах. Этот факт, при большом количестве известных архитектур моделей и заранее обученных моделей в так называемых "зоопарках", делает возможным практическое применение состязательных примеров, что представляет серьезную угрозу системам, использующим ИИ.

Даже система, которая кажется устойчивой к модификациям информации на входе (например, такая, которая использует локальную, не взятую из облака модель ИИ, напрямую соединенную с сенсорами), не застрахована от какой-либо состязательной атаки. Например, могут быть осуществлены физические атаки на модели, даже те, которые считаются "черным ящиком" без доступа к составляющим внутренней модели. Также могут быть введены состязательные примеры в процесс логического вывода модели, создавая упомянутые возмущения за счет обычных стикеров, приклеенных к предметам, и заставляя результирующий вывод отклоняться от оптимального решения.

Когда устройство входа модели ИИ неустойчиво против состязательных атак, чистый эффект таких атак может быть точно оценен до того, как придется решать, следует ли применять меры противодействия и какие именно и какое их количество считать достаточным. Возможность состязательных атак в реальной системе варьируется в широких пределах, в зависимости оттого, как внедрена модель ИИ. Например, эта возможность очень зависит от систем, окружающих технологию ИИ, включая получение входных данных через сенсор (например, камеру) и предварительную обработку данных. Более того, анализ возможных агрессоров и их жертв тоже важен, если единственные возможные жертвы совпадают с возможными агрессорами, в некоторых случаях можно просто не применять защитных мер.

Одна из предлагаемых мер для решения проблемы называется состязательным обучением. По сути, состязательное обучение пытается обучить систему ИИ на примерах, пытается заставить модель закодировать знания об ожидаемых данных на выходе при такой атаке. Другое направление - попытка устранить искусственно введенное возмущение.

Типы моделей, подверженные состязательным атакам, в целом являются робастными по отношению к шуму. Чтобы модифицировать ввод и повысить робастность по отношению к злонамеренному, направленному шуму, применяют различные схемы рандомизации. Методы включают случайное изменение размера и замощение изображения, случайные самоансамбли (random self-ensembles) и разные трансформации данных на входе, такие как сжатие JPEG или модификация битовой глубины на изображениях. Хотя такие методы эффективны, но не всегда достаточны. В свою очередь, если трансформации на входе используются как слой защиты от состязательных примеров, эффективность упомянутых мер можно оценить, используя алгоритм ожидания преобразования (expectation over transformation, EOT).

Использование моделей на основе нелинейных компонентов делает их менее подверженными состязательным атакам за счет возрастающих вычислительных ресурсов. Ансамбли моделей часто используются для создания более робастной общей модели путем диверсификации. Однако диверсификация не всегда в должной степени защищает систему от состязательной атаки.

В дополнение к атакам, изменяющим данные на выходе в функционирующей системе, можно ввести возмущение во время обучения модели, введя злонамеренные данные на этапе обучения, что называется "отравление модели". Учет необходимости защиты процесса обучения на этапе сбора данных очень важен.

8.6 Проблемы аппаратных средств, связанные с применением ИИ

Технология ИИ не может сама по себе принимать решения, она полагается на алгоритмы, программные средства, применяющие алгоритмы, и аппаратные средства, выполняющие эти алгоритмы. Сбои в оборудовании могут нарушить правильное выполнение алгоритма, нарушив ход исполнения (вызывая ошибки доступа к памяти, помехи в данных на входе, например от сенсоров), повреждая данные на выходе и в целом вызывая ошибочные результаты. В настоящем подразделе описываются некоторые аспекты аппаратных средств при использовании технологии ИИ, которые могут повлиять на функциональную безопасность. Коротко, надежное оборудование также важно для систем ИИ, как и для систем без ИИ. Так же, как оборудование, используемое для выполнения обычных программ, оборудование для выполнения программ технологии ИИ может быть подвержено случайным отказам. Перечень отказов приведен в ГОСТ Р МЭК 61508-2 и [9].

8.7 Зрелость технологии

Зрелость технологии отражает то, насколько зрелой и свободной от ошибок является конкретная технология в конкретном контексте применения. Менее зрелые и новые технологии, используемые при разработке систем ИИ, могут привнести риски, которые ранее не были известны и которые трудно оценить. Для зрелой технологии существует разнообразный опыт применения, что позволяет легче выявить риски, оценить их и принять против них меры. Однако зрелые технологии приводят к опасности сниженного осознания их потенциального воздействия на риск со временем, так что положительные эффекты зависят от постоянного мониторинга риска (например, на основе сбора полевых данных), а также в части соответствующего обучения сотрудников и от технического обслуживания системы.

9 Приемы верификации и валидации

9.1 Введение

В настоящем разделе приведено описание различий между методами верификации и валидации для систем с ИИ по сравнению с системами без ИИ, а также описание некоторых соображений для решения или смягчения проблем, возникающих из этих различий, применимых к функциональной безопасности. В настоящем разделе рассматриваются четыре важных аспекта указанных различий, хотя потенциальные различия не ограничиваются теми, которые здесь описаны.

Настоящий раздел посвящен моделям, которые созданы в процессе МО. В 8.1.2 этот класс моделей рассмотрен в качестве главной проблемы обеспечения функциональной безопасности системы ИИ. Это происходит потому, что функциональная безопасность других типов технологии ИИ может быть иногда достигнута путем применения принципов из существующих стандартов функциональной безопасности, которые описаны в разделе 7. Содержание настоящего раздела предназначено в основном для применения на уровнях использования от A1 до C класса II систем ИИ (см. таблицу 1, 6.2).

Для создания функционально безопасных систем, использующих ИИ на основе информационно обоснованных моделей, принимается во внимание то, что технология ИИ не создается правилами, как это происходит в системах, созданных без применения ИИ. Это значит следующее:

- то, чего нет в данных, выучить нельзя;

- то, что есть в данных, может быть выучено, но не всегда в совершенстве.

Более того, просто иметь данные в большинстве случаев оказывается недостаточно. Разметка имеет решающее значение при применении обучения с учителем. Неправильная разметка является одной из главных причин ошибок в процессе обучения. Подробно описанный процесс подготовки данных важен при обращении к этим аспектам.

Если модель получена на основе данных, содержание настоящего раздела может применяться для обучения и валидации наборов данных.

Примечание - Термины "валидация" и "верификация" могут относиться к разным понятиям в разных сферах. В контексте МО валидация означает шаг в процессе для проверки сходимости разрабатываемой модели для завершения процесса обучения ИИ, что совершенно отличается от понятия верификации и валидации в сообществе экспертов по функциональной безопасности. Сходимость модели является важным предварительным условием для тестирования, но она не означает гарантий качества конечного продукта. Например, проблема незаслуженного вознаграждения возникает из-за модели, которую субъективно создали для максимизации заданной функции вознаграждения. В настоящем стандарте термины валидация и верификация почти исключительно используются в контексте функциональной безопасности.

9.2 Проблемы верификации и валидации

9.2.1 Отсутствие априорной спецификации

На этапе обучения моделей МО выбор обучающих данных (вместе с определением функции потерь, если применимо) заменяет определение формализованной спецификации операционного поведения. Это приводит к проблемам с прослеживаемостью отдельных аспектов поведения ввиду отсутствия отдельных утверждений спецификации. Вместо этого информация, которая заменяет дискретные операторы спецификации, неявно содержится в обучающем наборе данных. Хотя преимуществом МО является его способность извлекать или приобретать знания из плохо структурированных данных, отсутствие заранее определенной спецификации может вызвать серьезную проблему верификации и валидации, а также оценивания неопределенности.

Другим источником риска является наличие систематической ошибки или неполноты данных, используемых для обучения модели. Необходимо применение техник для проверки обоих источников риска.

9.2.2 Неотделимость определенного поведения системы

При разработке ПО для приложений без ИИ, связанных с функциональной безопасностью, все риски, которые были описаны в разделе 8, и в процессе анализа опасностей и оценки рисков (hazard and risk analysis, HARA) были идентифицированы как "допустимые", сопоставлялись с одной или несколькими мерами снижения рисков. Необходимо должным образом реализовать внедрение мер снижения рисков и объяснить их роль для функциональной безопасности. Также важно, чтобы меры не создавали помехи друг другу для проведения верификации, валидации и оценки каждой из них.